데일리연합 (SNSJTV. 타임즈M) 윤태준 인턴기자 | 중국의 AI 스타트업 딥씨크(DeepSeek)가 내놓은 새로운 대화형 AI 모델 ‘DeepSeek R1’이 세계 시장을 뒤흔들고 있다. 특히 미국 빅테크 업체들이 거액의 자금을 쏟아붓고도 만들지 못한 성능을, 훨씬 적은 비용으로 구현했다는 소식에 업계가 술렁이고 있다.

물론, 중국발 AI 모델이라는 점이 의혹을 부추기고 있지만, 딥씨크 측이 공개한 논문 내용과 시연 영상을 보면 이들의 기술적 성과가 ‘보여주기식 발표’만은 아니라는 게 전문가들의 중론이다. 딥씨크가 어떻게 대규모 투자 없이, 그리고 많은 인원 없이 새로운 언어 모델을 개발할 수 있었는지 논문에서 나온 내용을 기반으로 짚어보자.

LLM의 기본, “데이터가 곧 힘”이라는 기존 공식

ChatGPT와 같은 대화형 AI 모델을 우리는 ‘LLM(Large Language Model, 거대언어모델)’이라 부른다. LLM은 수많은 텍스트 데이터를 학습해 인간처럼 ‘자연어’로 정보를 주고받을 수 있다. 기존 컴퓨터가 코드를 통해서만 작동했다면, 이제 인간의 언어로 대화하듯 사용하게 됐으니 ‘혁신’이라 불릴 만하다.

문제는 LLM의 엄청난 비용 구조다. 인간이 대화를 할 때 단어 그 자체만 이해하는 것이 아니라, 단어와 단어 사이의 ‘맥락’을 파악하듯이, AI가 이를 흉내 내기 위해서는 막대한 양의 언어 데이터를 학습해야 한다. 이를 ‘사전학습(Pre-training)’이라 부른다.

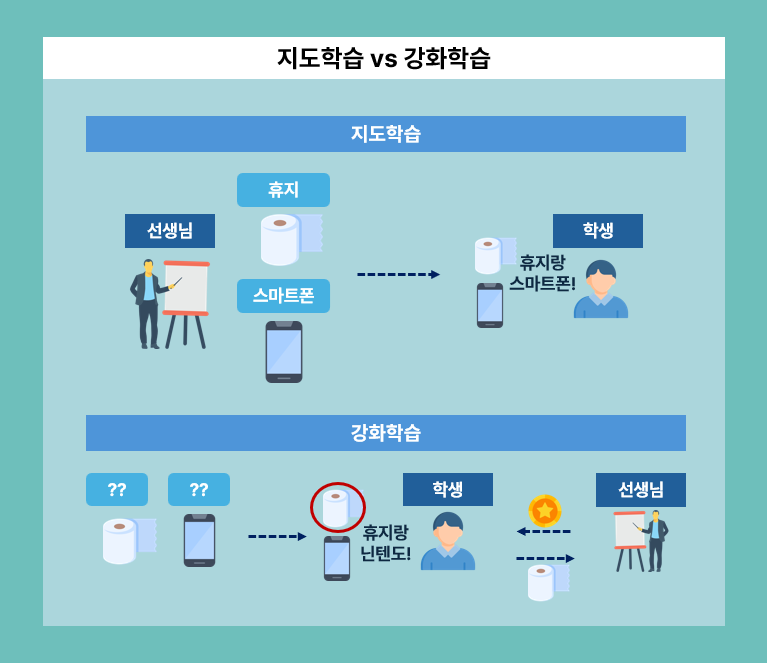

그러나 이렇게 학습된 모델은 자기 답변이 맞는지 틀린지 모른다. 때문에 누군가 정답을 끊임없이 알려주는 ‘지도학습(Supervised Fine-tuning, SFT)’이 필요하다. 오늘날 보편적으로 활용되는 LLM은, 이 사전학습과 지도학습을 기반으로 성능을 고도화해왔다.

딥씨크, “학습 패러다임 자체를 부쉈다”

딥씨크가 내놓은 DeepSeek R1-Zero가 화제가 된 이유는 지도학습을 아예 배제했다는 점이다. 오직 ‘강화학습(RL, Reinforcement Learning)’만으로 모델을 학습했다.

쉽게 말해, 지도학습은 선생님이 문제를 풀기도 전에 답을 알려주는 방식이라면, 강화학습은 학생이 직접 문제를 풀고 정답일 때만 칭찬(보상)을 받는 구조다.

문제는 여기서 언어 장벽이 생긴다는 점이었다. 중국어 문제는 중국어로 생각하고, 영어 문제는 영어로 생각하다 보니, AI가 내놓는 답변에 두 언어가 섞여버리는 현상이 발생한 것이다. 사용자 입장에선 가독성이 크게 떨어질 수밖에 없다.

소량의 데이터 + 미량의 지도학습

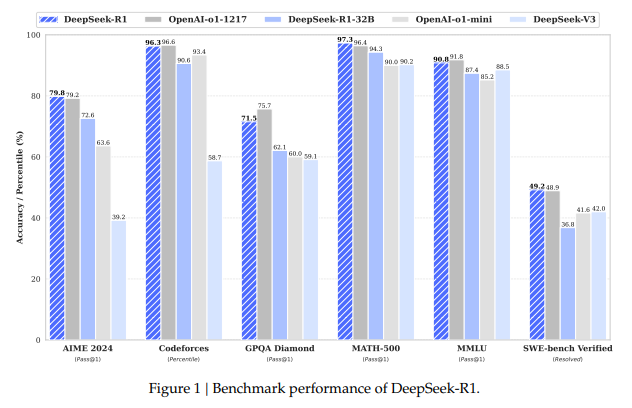

이 언어 혼합 문제를 해결하기 위해 딥씨크 연구진이 내놓은 해법이 DeepSeek R1 모델이다. 혼자서만 학습하던 R1-Zero에 아주 소량의 고품질 데이터(Cold Start-Data)와 일부 지도학습을 접목시킨 것이다. 그랬더니 언어 혼용 문제가 해결됐을 뿐 아니라, 모델 성능까지 이전보다 대폭 높아졌다고 한다.

고작 이 금액으로? '가성비 최강'

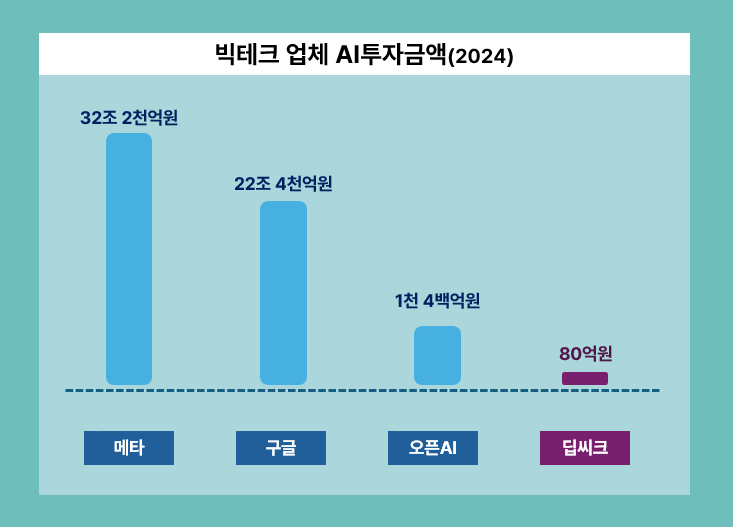

딥씨크 측에 따르면 DeepSeek R1 모델 개발에 쓴 돈은 불과 5.6백만 달러(약 80억 원). 반면 구글, 메타, 오픈AI 등 미국 빅테크 업체들이 올해 쏟아부은 자금은 많게는 수십조 원에 달한다. 투자금에서만 보면 무려 18배~400배 가까이 차이가 난다.

더 놀라운 건, 딥씨크가 GPU(Graphics Processing Unit) 수급에서 미국의 규제를 받았음에도 이 같은 성과를 냈다는 사실이다. 최상급 GPU를 쓰는 것이 아니라, 낮은 사양의 반도체 칩으로도 ChatGPT 이상의 성능을 내는 AI 모델을 만들었다는 점이 투자자들의 시선을 사로잡고 있다.

“기존 투자, 과잉이었나”… 빅테크 흔드는 충격파

딥씨크의 논문 발표 직후 엔비디아(-16.97%), 브로드컴(-17.4%), 알파벳(-4%) 등 관련 주가가 급락했다. 소규모 예산과 성능 낮은 칩으로도 가능성을 증명해낸 DeepSeek R1을 계기로, 그간 빅테크 업체들의 수십조 원대 투자가 ‘당연한 선택’이었는지 의문이 제기되기 시작한 것이다.

물론, 딥씨크 발표 자료와 투입 비용이 모두 공식 검증된 것은 아니다. 그럼에도 DeepSeek R1을 실제 사용해본 이들은 “ChatGPT보다 성능이 떨어지지 않고, 오히려 우수하다”는 평가를 내놓고 있다.

젊은 139인 연구진의 ‘창의성’이 만든 역사

딥씨크에는 고작 139명 정도가 몸담고 있다. 반면, 오픈AI만 해도 1,400명 이상이다. 더욱이 딥씨크 연구진 대부분이 중국 대학 출신의 20~30대 청년들이다. 이들은 막대한 자본 대신 창의적 아이디어를 무기로 삼았고, 연구 성과를 전부 오픈소스로 공개했다. “AI 모델은 전 세계인이 자유롭게 활용해야 한다”는 철학도 함께 강조했다.

LLM 전쟁, 누가 왕좌를 차지할 것인가

현재 DeepSeek R1 모델이 일으킨 파장은 단순히 ‘새로운 기술의 등장’ 이상의 의미가 있다. 막대한 자본 없이도, 최고 사양 칩 없이도 AI 생태계에서 최고 수준의 성능을 뽑아낼 수 있다는 것을 증명했기 때문이다.

하지만 아직 모든 것이 검증된 것은 아니다. 딥씨크가 내놓은 수치와 실험 결과가 향후 철저한 검증 과정을 거치게 될지, 혹은 또다른 혁신으로 빠르게 대체될지 전 세계가 주목하고 있다. 빅테크 업체들은 과연 이 돌풍에 어떤 대응책을 내놓을까. LLM의 새 시대가 열리는 현장을 지켜보는 재미가 더욱 커지고 있다.

▶아이타임즈M 이슈보도탐사팀 제보하기

▷ 전화 : 1661-8995

▷ 이메일 : god8889@itimesm.com

▷ 유튜브, 인스타 뉴스 구독해주세요!